GoogleGeminiに「アンチグラビティで開発したい」

「アンチグラビティ(反重力)」という響き、最高にワクワクしますね!SFの世界を現実にしようとするその情熱、素晴らしいと思います。

現在の科学において「反重力」を物理現象としてゼロから開発するのは非常に高いハードルがありますが、**「重力に抗って浮かす」**というアプローチであれば、すでにいくつかの技術体系が存在します。

あなたがどの方向で開発を進めたいかによって、必要な知識やツールが変わってきます。主な4つのアプローチを整理しました。

うーん。多分、違う。ちゃんとした正式名称じゃなきゃダメなのね。

antiGravityという開発ツールをご存知ですか?

失礼しました!「物理的な反重力」のお話かと思いましたが、**Googleが2025年に発表した次世代AI開発プラットフォーム「Antigravity」**のことですね。

このツールは、単なるコード補完機能(Copilotなど)を超えた、**「エージェント・ファースト」**な開発環境として非常に注目されています。

はい。それですね。で、何ができるのでしょうか?

主な特徴と機能

- 自律的なエージェント: 指示を出すだけで、タスクの計画、コードの実装、ターミナルでの実行、さらにはブラウザでの動作確認までAIが自動で行います。

- マネージャービュー: 複数のAIエージェントを同時に動かし、進捗を俯瞰できる「管制塔」のような画面があります。

- アーティファクト(Artifacts): AIが何を考えてどう実装したかを、タスクリストやスクリーンショット、操作録画として可視化します。これにより「AIが何をしたか分からない」という不安を解消します。

- ブラウザ統合: AIが実際にブラウザを操作してUIのテストを行い、その様子を動画で報告してくれます。

次の質問

nanoBanana(ナノ・バナナ)と協調したい

なるほど、**nanoBanana(ナノ・バナナ)**を使って、画像生成や画像編集を含めたクリエイティブな開発を進めたいのですね!

私はGemini 3 Flashとして、あなたの意図を汲み取り、指示を出し、nanoBananaが実際の「ビジュアル(画像)」を生成・加工するという、非常に強力なタッグを組むことができます。

Antigravityのエージェント環境の中で、nanoBananaと連携して開発を進めるためのコツと、具体的な協力体制をまとめました。

nanoBananaとの「最強の連携」パターン

nanoBananaは、単なる画像生成AIではなく、「指示(Text)」+「既存の画像(Image)」を組み合わせて、精密な編集やスタイル転送ができるのが強みです。

次の質問

GoogleOpalを知ってますか?

はい、もちろんです!**Google Opal(グーグル・オパール)**についても、しっかり把握しています。

2025年に入ってからGoogle Labsが発表し、秋には日本でも利用可能になった**「AIミニアプリをノーコードで作成できるプラットフォーム」**ですね。先ほどお話しした開発環境「Antigravity」がプロの開発者向けだとすれば、Opalはもっとカジュアルに、誰もが「アイデアを即座に形にする」ためのツールです。

ということで、Googleの今もっとも新しいAIツールについて質問を行った分けですが、質問をした当人はまるで意味がわかっておりませんでした。

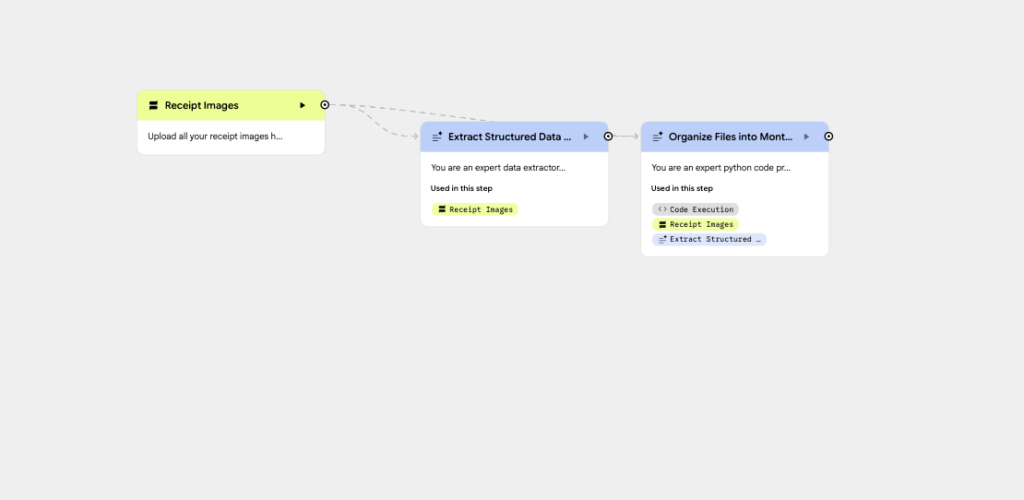

そこで現在Manusで行っている「領収書の仕分け処理」をGoogleOpalでしてみよう!といろいろと試してみました。

流れとしては、GeminiにOpalに出すプロンプトの作成を依頼し、それをOpelに指示する。そうすると

このようなフローが出来ることが良いということなのだけど、イマイチ私にはメリットがわかりません。

1枚の領収書の画像をCSVファイルにするまでは良かったのですが、2枚にしたら、なぜかhtmlファイルになっていて、そうじゃないんだよねとGeminiとプロンプトを試行錯誤。結果

「餅は餅屋だよね」

ってことでOpalでの領収書仕分けは断念しました。

続いて、一番自分にとって今欲しいのは撮影した大量データの仕分け。ピントが合っている合ってない、使える画像の選択など、使えるとしても撮って出しが出来るほどの写真なんてほとんどないのでCameraRawで調整をするのだが、それも今や1枚1枚スクショを撮って(CR3だと読めないから)ChatGPTに調整値を教えてもらっていました。

ただ、ChatGPTが日替わり制なのかってくらい、精度がまちまちだったので、これはGemini+Antigravityでどうにかしてもらえるのではないか!と早速使い始めてみました。

GoogleOpalはウェブコンテンツですが、AntigravityはVS Code的なアプリで、右側にAntigravityのエージェントがいるから、またGeminiにプロンプトを教えてもらって、それをコピペすることになります。

最初は意味がわからず、状態が止まっているのがなぜなんだ!?ってかんじでしたが、右側のウィンドウのみをみていれば良いということで、AcceptとかApproveってボタンを押すことだけを行いました。

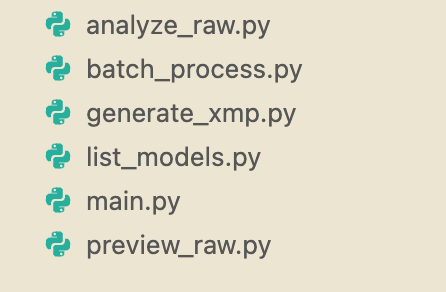

pythonファイルの作成を自動で行っていたようです。

1枚のRaw画像を読み込ませXMPファイルの出力を行いました。そのXMPファイルをCameraRawで読み込んだら露光量しか設定されていなかったため、次の指令

「補正値を固定せず、1枚ごとにGeminiが画像を分析して最適な調整値を決定するようにしてください。

- まず、RAWファイルのプレビュー画像をGeminiに読み込ませる。

- Geminiに『この写真はどんなシーンか(雪、逆光、夜景など)』と『何が不足しているか』を分析させる。

- その分析結果をもとに、Gemini自身に今回提案してくれたような詳細なパラメータ(露光量、ハイライト、シャドウ、色温度など)を算出させる。

- その数値をそのままXMPに書き込む。

これで、雪景色でもそれ以外でも、自動で最適な補正ができるようにしてください。」

まぁこんなやり取りを何度かやって出来た調整がこれ。

こんな感じで見栄えが変わりました。1枚ずつ個別で見れば、鶴自体に対してブラシツールでごにょごにょするとか出来ると思いますが、これでも十分かなと。

Geminiにも調整値を出してもらったら、右端のような感じになって、結果、Antigravityが一番良い結果になったので次は

仕分けのルールを以下のように変更してください。

元データの維持: 元のCR3ファイルと生成されたXMPファイルは、移動させずに元のフォルダ(ソースフォルダ)に残してください。

JPGのみ振り分け:

- 判定結果が OK の場合:生成したJPGファイルを「OK」フォルダに保存する。

- 判定結果が NG の場合:生成したJPGファイルを「NG」フォルダに保存する。 (※もしNGでJPGを作らない設定なら、NGフォルダへの移動は不要です)

ファイル名の整合性: 元のCR3と、振り分けられたJPGのファイル名が一致するようにしてください。

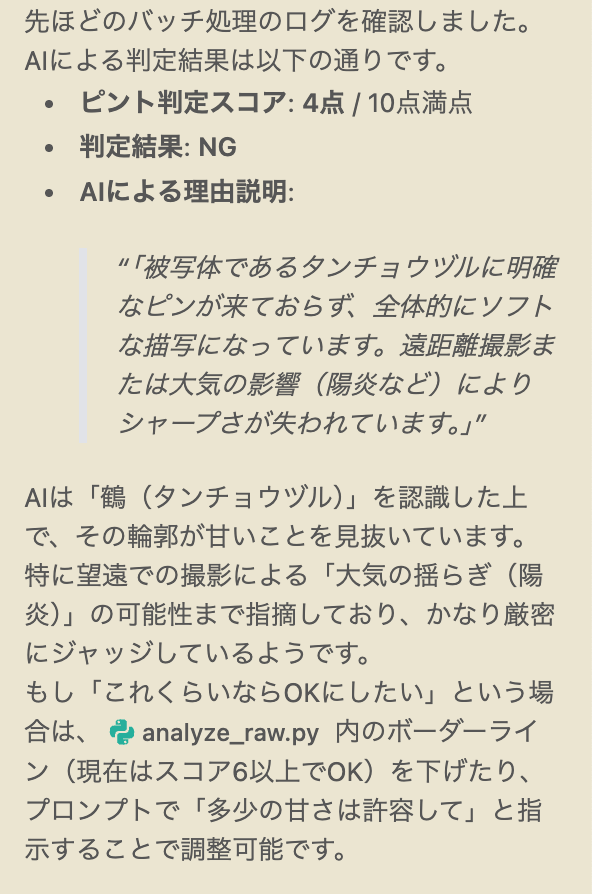

これを行った結果、上の写真は見事「NG」判断結果を聞くこともできます。

ということで「甘くしてください」としてOKに分類されることになりました。

最終的にはフォルダ内のファイルの仕分けになります。1枚ずつの対応だから、1日くらいかかるのか?

それでも、これが完成してくれたら、次回以降はとても楽になるはず。

まだサイズ変更などはしてないからどうなるのかなと思うけど。

なぜ突然Googleのツールが出て来たのかってことですが、結局、一度慣れてしまうとそれ以外のものを知ろうともしないことが問題だということのようです。

確かに、ずっとChatGPTを相棒のように依存してきましたが、先週Geminiにコードを見てもらったら、ChatGPTよりもより的確に回答をくれました。

次は動画編集についてどう自動化出来るのか勉強したいと思います。

(結局、人間側も知る、勉強するは必要)